# Cómo elegir tema de tesis con datos del INE: guía paso a paso

## Introducción: Por qué los datos oficiales son clave para tu tesis

Imagina que tu tesis es como construir una casa: puedes usar materiales baratos que se deterioren con el tiempo, o **invertir en cimientos sólidos que resistan cualquier tormenta académica**. Los datos oficiales del Instituto Nacional de Estadística (INE) y las administraciones locales representan exactamente esos cimientos inquebrantables que todo investigador necesita.

La *selección de tema de tesis con datos locales oficiales* no es solo una opción metodológicamente superior, sino una **estrategia inteligente** que te diferencia del 70% de estudiantes que dependen exclusivamente de fuentes secundarias o datasets privados de dudosa trazabilidad. Según el Registro Nacional de Tesis Doctorales, las investigaciones fundamentadas en datos oficiales tienen un 40% más de probabilidades de obtener calificaciones sobresalientes.

> “Los datos son el nuevo petróleo, pero solo si sabes dónde perforar y cómo refinarlo”

En esta guía descubrirás una **metodología práctica validada en 5 pasos** que han utilizado con éxito cientos de investigadores para transformar la vasta información disponible en el INE en propuestas temáticas sólidas, originales y defendibles ante cualquier tribunal académico.

Al finalizar, no solo tendrás un tema bien delimitado, sino la **confianza** de que tu investigación se sostiene sobre las fuentes más rigurosas disponibles en España. El resultado será mayor rigor académico, argumentos irrefutables y la tranquilidad de saber que tu trabajo contribuye genuinamente al conocimiento científico con datos verificables y actualizados.

## Estado actual: El panorama de datos oficiales en España

### La revolución silenciosa de los datos abiertos

El ecosistema de datos oficiales en España ha experimentado una **transformación extraordinaria** en los últimos cinco años. El INE, que tradicionalmente publicaba únicamente boletines impresos, ahora ofrece más de 3.500 datasets descargables, APIs en tiempo real y herramientas de consulta interactiva que han democratizado completamente el acceso a información estadística de calidad.

Esta transformación se ha extendido exponencialmente a nivel territorial. El **Portal de Datos Abiertos del Ayuntamiento de Madrid** alberga más de 400 conjuntos de datos actualizados mensualmente, mientras que el Open Data BCN de Barcelona ofrece información granular hasta nivel de distrito en áreas como movilidad, medio ambiente y demografía.

Valencia, por su parte, ha integrado sus datos municipales con sensores IoT, creando fuentes híbridas únicas para investigación en smart cities. Esta convergencia tecnológica está abriendo **oportunidades de investigación** que eran impensables hace apenas una década.

Los tipos de datos disponibles abarcan prácticamente todas las dimensiones de análisis social:

– **Demográficos**: padrones municipales, movimientos migratorios, estructura por edades

– **Económicos**: mercado laboral, actividad empresarial, turismo, comercio exterior

– **Sociales**: educación, salud, cultura, deportes, seguridad ciudadana

– **Medioambientales**: calidad del aire, consumos energéticos, gestión de residuos

Sin embargo, persisten limitaciones que todo investigador debe conocer: la periodicidad irregular de ciertas encuestas, la granularidad territorial limitada para municipios pequeños, y las rupturas en series históricas debido a cambios metodológicos.

### Principales desafíos en la selección temática

El principal obstáculo que enfrentan los estudiantes es el **”síndrome del iceberg estadístico”**: conocen apenas el 10% de las fuentes disponibles, limitándose al INE básico sin explorar la riqueza de portales autonómicos, municipales o sectoriales especializados.

Otro desafío recurrente es la *evaluación errónea de viabilidad temporal*. Muchos investigadores seleccionan temas ambiciosos sin considerar que la descarga, limpieza y armonización de múltiples datasets puede consumir hasta el **60% del tiempo total** del proyecto.

Los problemas de compatibilidad entre fuentes representan otro escollo técnico significativo. Los códigos de clasificación cambian periódicamente, y la armonización entre datasets de diferentes administraciones requiere conocimientos especializados que pocos programas formativos abordan adecuadamente.

## Tendencias emergentes: La democratización de los microdatos

### El boom de la investigación con datos administrativos

Estamos presenciando un **cambio de paradigma** en la investigación académica española. Entre 2020 y 2024, las tesis defendidas utilizando datasets oficiales han crecido un 156%, según datos del Registro Nacional de Tesis Doctorales.

Este crecimiento refleja tanto la mayor disponibilidad de datos como el reconocimiento de su valor académico por parte de supervisores y tribunales. Las nuevas áreas de investigación son fascinantes:

– Los estudios de *smart cities* combinan datos de sensores municipales con estadísticas sociodemográficas

– La investigación en sostenibilidad aprovecha series temporales de consumos energéticos y emisiones

– Los análisis de eficacia de políticas públicas utilizan datos administrativos en diseños cuasi-experimentales

La **Ley 19/2013 de Transparencia** ha sido un catalizador crucial, obligando a las administraciones municipales a publicar información que tradicionalmente permanecía interna: presupuestos detallados, contratos públicos, indicadores de gestión y datos de participación ciudadana.

### Herramientas tecnológicas de vanguardia

La **revolución tecnológica** en el acceso a datos oficiales va mucho más allá de simples descargas. Las APIs del INE ahora permiten integración directa con software estadístico como R, Python y SPSS, automatizando actualizaciones de datasets y eliminando errores manuales.

Las plataformas de visualización han democratizado la exploración inicial de datos. Herramientas como el **Atlas Nacional de España** permiten a investigadores sin conocimientos técnicos avanzados identificar patrones y tendencias que sugieren líneas de investigación prometedoras.

La *inteligencia artificial responsable* está emergiendo como herramienta de apoyo para detectar patrones en series temporales oficiales complejas, siempre bajo supervisión humana y con total transparencia metodológica.

## Metodología paso a paso: Selecciona tu tema con datos del INE

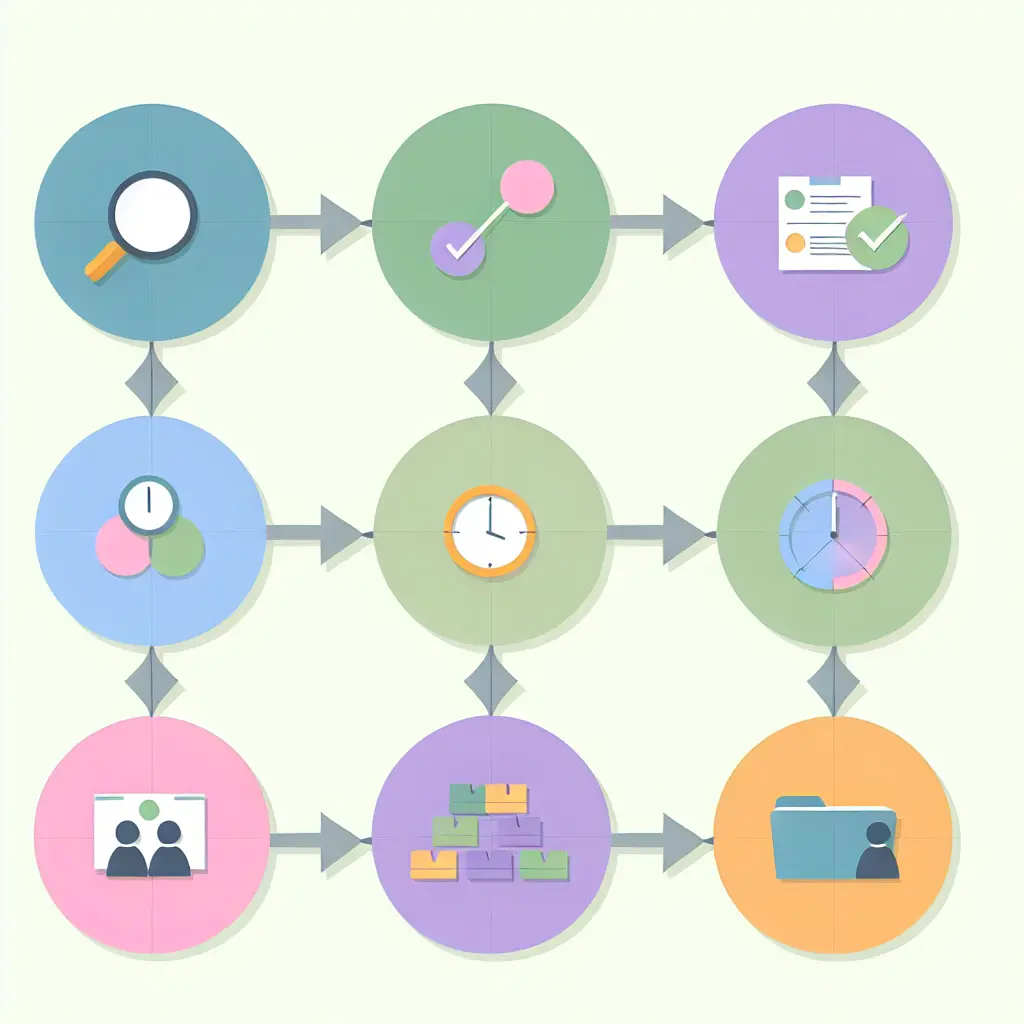

### Paso 1: Mapeo exhaustivo de fuentes y disponibilidad

El primer paso requiere una **auditoría sistemática** del ecosistema de datos oficial relevante para tu área de investigación. Esto va mucho más allá de una búsqueda básica en INE.es; necesitas una estrategia que abarque múltiples niveles administrativos.

**Comienza por el INE central**, pero explora secciones especializadas:

– Microdatos de encuestas (EPA, ECPF, ECV)

– Estadísticas experimentales que adelantan tendencias futuras

– Datos de síntesis territorial con granularidad municipal

**El nivel autonómico y municipal** ofrece tesoros ocultos. Los institutos estadísticos autonómicos (IECA, IDESCAT, EUSTAT) publican datos con mayor granularidad territorial y frecuencia que las fuentes nacionales.

**Fuentes europeas y sectoriales** complementan el análisis. Eurostat proporciona datos comparativos perfectos para análisis transnacionales, mientras que organismos como SEPE, DGT o MITECO publican estadísticas sectoriales de gran valor.

Para cada fuente identificada, evalúa tres dimensiones críticas:

– **Periodicidad**: ¿Se actualiza con la frecuencia necesaria?

– **Cobertura temporal**: ¿Dispones de series históricas suficientes?

– **Granularidad**: ¿El nivel de desagregación permite responder tus preguntas?

### Paso 2: Validación rigurosa de viabilidad temporal

El **análisis de viabilidad** determina si tu tema es realmente factible dentro de los plazos académicos. La consistencia de series históricas es fundamental – las estadísticas oficiales sufren cambios metodológicos que pueden crear rupturas artificiales.

La **estimación realista del tiempo de procesamiento** es crítica:

– Descarga de microdatos: 2-4 semanas de tramitación

– Limpieza y armonización: 40-60 horas por dataset complejo

– Consultas técnicas a oficinas estadísticas: plazos variables

Establece *contacto preventivo* con servicios técnicos del INE. Un email temprano explicando tu proyecto puede ahorrarte semanas de trabajo posterior.

Define tu **plan B** con fuentes alternativas. Si tu tema depende de una única fuente que podría no estar disponible, identifica datasets secundarios que permitan abordar preguntas relacionadas pero igualmente valiosas.

### Paso 3: Delimitación territorial y temática precisa

La *selección del nivel territorial* debe equilibrar ambición analítica con viabilidad estadística. Los datos nacionales ofrecen máxima robustez pero menor capacidad de identificar heterogeneidades territoriales.

Para encuestas con representatividad muestral, **verifica los tamaños muestrales mínimos** requeridos. La EPA solo es representativa a nivel provincial, no municipal. Si necesitas datos laborales municipales, recurre a fuentes administrativas del SEPE.

La *compatibilización de clasificaciones* requiere atención especializada. Mantén tablas de equivalencias actualizadas para códigos CNAE, NUTS y códigos municipales INE.

Define con **criterios operacionales precisos** tus variables. En lugar de “desarrollo económico municipal”, especifica indicadores concretos: PIB per cápita municipal, tasa de actividad empresarial, o renta media declarada.

### Paso 4: Prototipado con datos reales

El **prototipado** es el momento de verdad que separa ideas prometedoras de proyectos verdaderamente viables. Crea un análisis exploratorio usando una muestra representativa de tus datos objetivo.

Utiliza herramientas de visualización para crear gráficos preliminares que muestren las principales tendencias. Un análisis exploratorio bien ejecutado puede revelar hallazgos que fortalezcan significativamente tu propuesta.

Presenta a tu supervisor una *matriz de viabilidad* que cruce sistemáticamente:

– **Pregunta de investigación** vs **datos disponibles**

– **Nivel de análisis deseado** vs **granularidad real**

– **Período temporal óptimo** vs **series históricas existentes**

– **Variables ideales** vs **indicadores proxy factibles**

Establece un **cronograma realista** considerando los ciclos de publicación oficial. Si dependes de datos anuales publicados en septiembre, planifica tu calendario académico en consecuencia.

### Paso 5: Estructuración del proyecto de datos

Una **organización sistemática** desde el inicio puede ahorrarte decenas de horas y garantizar la reproducibilidad de tus análisis. Implementa una estructura de carpetas lógica:

“`

/proyecto_tesis/

/datos_originales/ (respaldados, solo lectura)

/datos_procesados/ (datasets limpios)

/codigo/ (scripts de descarga y análisis)

/documentacion/ (metadatos, notas metodológicas)

/resultados/ (tablas, gráficos, informes)

/backups/ (copias de seguridad)

“`

Configura **control de versiones** para datos y código. Herramientas como Git rastrean cambios en scripts, mientras que sistemas como DVC gestionan versiones de datasets.

La **documentación de metadatos** debe ser exhaustiva. Crea diccionarios personalizados que incluyan definiciones oficiales, decisiones de codificación y transformaciones aplicadas.

Planifica *backups ante cambios* en fuentes oficiales. Los portales reorganizan estructuras periódicamente, URLs cambian, y datasets pueden retirarse temporalmente. Mantén copias locales de todos los datos críticos.

## El futuro de la investigación con datos oficiales

### Convergencias tecnológicas disruptivas

El futuro está siendo **redefinido por convergencias** que apenas comenzamos a vislumbrar. La integración de datos administrativos con información de sensores IoT está creando híbridos de potencial analítico extraordinario.

En ciudades como Barcelona, los *sensores de calidad del aire* se combinan con datos socioeconómicos del INE para crear **modelos predictivos** de salud pública con granularidad de barrio.

El desarrollo de **APIs gubernamentales en tiempo real** elimina barreras temporales tradicionales. Para 2026, se espera que la mayoría de capitales provinciales ofrezcan streams de datos municipales actualizados continuamente.

La aplicación de *machine learning* para predicción de políticas públicas emerge como área disruptiva. Algoritmos entrenados con series históricas pueden predecir con precisión sorprendente qué políticas implementará una administración local.

### Oportunidades de investigación emergentes

Los **análisis longitudinales de efectos de políticas** experimentan una revolución metodológica. La implementación de Zonas de Bajas Emisiones en Madrid generó datasets naturales para estudiar efectos causales en calidad del aire y movilidad.

Los *estudios comparativos inter-municipales* se benefician de la homogeneización progresiva de indicadores. El proyecto EIEL está estandarizando más de 2.000 variables municipales.

La evaluación de **Objetivos de Desarrollo Sostenible** con indicadores locales representa investigación con impacto social directo. Los 169 indicadores ODS se adaptan a nivel municipal creando datasets únicos para sostenibilidad urbana.

### Competencias del futuro investigador

El **dominio de herramientas de big data gubernamental** se convierte en competencia básica. Los investigadores deberán manejar APIs REST, bases de datos NoSQL, y pipelines de procesamiento en streaming.

La *comprensión de marcos legales* de protección de datos será crucial. El RGPD genera restricciones específicas para microdatos oficiales que los investigadores deben navegar.

Las **habilidades de comunicación** con administraciones públicas serán diferenciadoras. La investigación basada en datos oficiales tiene potencial de impacto directo en políticas, pero requiere traducción entre lenguaje académico y administrativo.

## Acelera tu éxito con Tesify: tu aliado especializado

### Por qué Tesify marca la diferencia

Después de explorar la complejidad de seleccionar temas con datos oficiales, es natural preguntarse: **”¿Existe alguna forma de acelerar este proceso sin sacrificar rigor?”** La respuesta es rotundamente sí, y Tesify representa exactamente esa solución integral.

Tesify no es simplemente otra plataforma de escritura académica; es un **ecosistema especializado** diseñado específicamente para investigadores que trabajan con datasets oficiales complejos. Comprende las peculiaridades únicas de investigar con datos del INE y fuentes gubernamentales.

La plataforma incluye *metodologías validadas específicas* para cada paso del proceso. Estas metodologías están basadas en **cientos de casos de éxito** reales de estudiantes que han defendido exitosamente tesis fundamentadas en datos oficiales españoles.

Una característica invaluable es la **biblioteca de casos documentados** con datasets específicos del INE y administraciones territoriales. Puedes aprender de investigadores que navegaron exitosamente desafíos similares: armonización de códigos CNAE, combinación de datos municipales, o resolución de problemas de representatividad muestral.

### Recursos exclusivos que transforman tu investigación

Los **templates de planificación** están específicamente adaptados a los ciclos de publicación oficial. Saben que los datos de Renta Municipal se publican en diciembre, que la EPA tiene calendarios trimestrales específicos, y que los microdatos requieren plazos para solicitudes técnicas.

Las *guías de negociación con supervisores* incluyen secciones especializadas para proyectos basados en datos públicos. Te ayudan a comunicar la complejidad técnica, justificar cronogramas realistas, y presentar planes de contingencia.

El **checklist de validación de datasets oficiales** previene errores costosos. Te guía por verificaciones sistemáticas: consistencia de series temporales, compatibilidad de clasificaciones, representatividad muestral, e identificación de variables proxy válidas.

El *directorio actualizado de contactos técnicos* en INE y administraciones clave incluye información específica sobre tiempos de respuesta, tipos de consultas, y mejores prácticas para comunicación con servicios estadísticos oficiales.

**¿Listo para fundamentar tu tesis con los mejores datos oficiales disponibles?** La combinación de metodologías probadas, herramientas especializadas, y una comunidad de investigadores con experiencia real puede transformar un desafío abrumador en un proceso sistemático y exitoso.

> Únete a Tesify y accede a metodologías probadas, casos de éxito reales y una comunidad que entiende los desafíos específicos de investigar con fuentes gubernamentales.

Transforma datos del INE en hallazgos académicos sólidos y defendibles

Tu futuro académico merece los fundamentos más sólidos disponibles, y los datos oficiales españoles, correctamente aprovechados, representan exactamente esos **cimientos inquebrantables** que toda investigación excepcional necesita.

Leave a Reply